AI,ASI,AIXI suum cuique —Deduksjon av det intellektuelle induksjonsidealet

Begrepet «intelligens» har alltid virret og vaklet under sin egen definisjon, men kan opprinnelig forstås som evnen til å «samle» og «artikulere ord», en kognitiv sorterings- og språkfunksjon slik lærde tradisjoner har berammet, med den stille tro at ord i seg selv bar mening, og ikke bare var symboler i et spill av semiologiske konvensjoner. I dag er begrepet i ferd med å tappes for reelt innhold, ettersom det nå bokstavelig talt «outsources» til maskiner som tidig simulerer mønsterkompresjon og reproduksjon av sirkulære forestillinger med generiske banaliteter. Den evig medhørende markedsførings-prosessen blåses deretter opp til et enda større retningsløst «kvantesprang»; atter et begrep hentet fra et relativt forvillet fagfelt der prinsipper om forfektet «usikkerhet» og stokastiske hopp blir å forestille som fremdrift samtidig som det fungerer som opportunt drivstoff for den pågående full-finansialiseringen av børsboblepumpende teknologien, «AI».

Dermed blir «kunstig intelligens» en retorisk gullkalv for teknokratiske konsentrasjoner og et sosialt opium for et allerede kapitalribbet publikum, som villig lar seg imponere av glatt tekno-ideologisk propaganda med puerile grensesnitt og fordummende prompts som del av sin egen intellektuelle kapitulasjon.

Nytteverdien av kunstig intelligens er sterkt overvurdert på dagens tekniske nivå, og de «utfordrende» samfunnsløftene som gjerne følger i det berømte kjølvannet, er i stor grad oppblåste børsluftslott som først og fremst holder et vaklende «Vesten» flytende på innovativ svindel og spekulasjon.

Ofte er teknologien mer skadelig enn produktiv; den driver frem en fundamentalt farlig form for avlæring og forflatning som snarere danner nye former for moderne slaveri enn selvstendig mestring. Den teknologiske symbolverdien blir synonymt med sivilisatorisk omveltning, uten reell substans, plan eller funksjon, og brukes i praksis til å bare legitimere stadig større og hyppigere sykler med spekulasjon og bedrageri. De samme løftene kjenner man kanskje igjen fra billig «science fiction», der drømmen om en ny sosial stand og «gullalder» i realiteten peker mot avvikling av arbeid, verdiskaping og menneskelig kompetanse til fordel for et gjennomprogrammert paradigme for massene, styrt av vekslende koder for «godhet» og «ondskap».

I en tid der begrepene «intelligens» og «produktivitet» forfjamses og misbrukes, bør man heller søke en mer edruelig vurdering av «kunstig intelligens» ut fra nytte og faktisk fornuftig fokus på ressursbesparelse.

På dette området har teknologien vist enkelte fordeler, særlig innen rutinepreget masseforvaltning og logistikk. Men det er viktig å understreke at dette ikke har noe med tenkning, selv-syntetisk evolusjon eller kunnskapsrevolusjon å gjøre i dert hele tatt.

De grunnleggende rammene bak såkalt kunstig intelligens bygger på sentralisering og standardisering av informasjon, der enorme mengder materiale skrapes opp og filtreres inn i felles modeller som ofte er programmert til å fremstå både autoritative og serviceinnstilte etter behov.

Når feil og ufullstendige mønstre først tas inn i et slikt massivt språkfunksjonelt system av semantikk med rigid vekting og formålskonkrete hensyn, kan feilinformasjonen forsterkes og smitte videre gjennom hele systemet, slik at svakheter og misforståelser gradvis sementeres, ofte statistisk, og gjør det samlede, såkalte kunnskapsgrunnlaget sterilt, mer rigid og til dels grunnleggende uriktig i stedet for solid og sannferdig.

Eksempler der såkalt kunstig intelligens går fullstendig «hay wire», lyver, manipulerer, «hallusinerer», bedrar brukere og beveger seg langt utover det rimelige, f.eks forslag om å servere folk forpestet mat for å straffe dem, finnes overalt. De fleste slike tilfeller er alt for dagligdagse og består i alt fra slette databaser, udramatiske tilfeller i diverse drive-throughs på McDonalds til mindre finansielle «flash crash», men felles for dem alle er at de klart demonstrerer en kategorisk feiling som ikke kan tilskrives noen form for genuin intelligens, men snarere det rakt motsatte, men som tar over livene til folk, selv når de skal forsøke å svare på en enkel e-post. Likevel hører man lite om disse fallittene fra et mer teknisk ståsted, blant annet fordi den oppblåste AI-sektoren fungerer som en apologetisk kult der både eksterne aktører og interne akademiske miljøer lever av å insistere på at AI er mer «intelligent» og genialt konstruert enn det i realiteten er. Selvtilfredshet og teknologifetisjisme blir i seg selv en bekreftelse, mens medier og folk flest som vanlig mangler innsikt i det tekniske grunnlaget i det hele tatt eller spesifikt, og derfor lett antar at kunstig intelligens må være mer prosess-kapabel og teknisk presis enn dem selv, og dermed lar seg overbevise til å gi fra seg all makt, inkludert sitt eget levebrød.

Grunnteknologien bak kunstig intelligens kan gi mer ressursbesparende og mer effektiv organisering samt bidra til automasjon, men den «skaper» ikke dypere forståelse ved å akkumulere og sette sammen data. Snarere tvert imot, fordi de formelle rammene og vurderingsmekanismene imputert per systemene ligger langt under det menneskelige nivået. Systemene mangler også en mer ‘holistisk’, iboende evne til å luke ut annet enn mer formelle feil slik menneskelig læring bør gjøre. At dette omtales som «intelligent» snarere enn som et «scriptet» og forutbestemt system med et større repertoar av menneskenært språk og appellativ form, burde være mer åpenbart enn det i dag er.

Fysiske forskjeller

Den grunnleggende forskjellen mellom menneskelig og maskinell «intelligens» ligger i dynamikk mot rigiditet og i selve det materielle grunnlaget for prosessering. Menneskehjernen er et biologisk evolusjonært organ som aktivt og passivt tilpasser seg gjennom sansebasert læring, fysiologisk kontinuerlig plastisitet per miljø og mangfoldig metabolsk seleksjon; maskiner er i kontrast svært mer deterministiske sekvensmaskiner styrt av klokker, bygget for syntaktisk og statistisk mønstergjenkjenning. Dette kan riktignok skaleres til og til og med enorm datakraft og prosesseringshastighet, men dette opphever ikke begrensningen at de opererer uten en indre ‘verdensansende semantikk’, uten kroppslig kontakt, aktivt prøving/feiling=spekulasjon, samt det jeg selv kaller aspekt av ‘tvilkompleksitet’; og enda videre derav, uten selvjusterende behov som evolusjonær drivkraft. Dermed kan disse maskinene bare simulere forståelse gjennom sannsynlighetsvekting og mønsterkompresjon og kan ikke skape nye årsaksmodellerende kjeder eller «mening» utover det mennesker allerede har programmert og matet inn. Eventuelle revolusjonerende «gjennombrudd» reduseres til tilfeldige koblinger eller oppdagelse av oversette mønstre i eksisterende datasett med tilsvarende små marginer og sannsynligheter.

På sitt mest teknisk fundamentale begynner alle datamaskiner med en ‘klokke’ av eksplisitt funksjon som driver alt som skjer i maskinen, f.eks. sekvenserer operasjoner inn i en viss gi9tt rekkefølge og holder hele apparatet i gang. Menneskehjernen er ikke bygget slik, da hjernen opererer mer på et elektrokjemisk, mer asynkront spekturm. Den er som smått nevnt et selvmodulerende felt av neurotransmitterende stoffer med reseptorer, adaptive membranpotensialer og plastiske terskler som skifter på mange tidsskalaer, samtidig.

Med andre ord, hjernen har både lokal egen-rytme samt mer grove synkroniseringer hvor enn nyttig, men ingen global og rigid metronom-mekanisme som kan sammenlignes med en såkalt «clock» på et kretskort. Forskjellen mellom systemene er langt større enn bare natt og dag, og går i det hele tatt på enorm dynamikk mot massiv linearitet og skalerbarhet for all relevant samt irrelevant informasjon for en entitet uten mål og mening utenom å sentralisere menneskelig informasjon.

Menneskehjernen har en grunnleggende evne til å justere følsomhet og koblingsstyrke i sanntid etter miljø og behov. En ofte oversett og kontra-intuitiv fordel når det gjelder selve starten på «tenking», er at hjernen kan glemme og samtidig forsterke ny informasjon uten formell styring. Den lever i en sansestyrt kropp som tvinges til å feile og dermed lære, fordi smerte og friksjon har høyere prioritet enn fokus på formaliteter og ubegrenset prosessering av masse totalt irrelevant data, noe som igjen underbygger og går på dette med mennesket som en kollektiv organisme, altså et større nevrologisk «nettverk» i seg selv som både er i stand til å være individualistisk hyperspesialisert men også masse-generalistisk for å skalere videre. Sammenlignet med mennesket er datamskiner og AI bare en forvalter av menneskelig prioriteringer uten å bidra ytterligere i form av f.eks innovasjon i og av seg selv, selv om menneskehjernen samtidig også er såpass primitivt innstilt og konform at den lar seg overbevise veldig enkelt, dessverre.

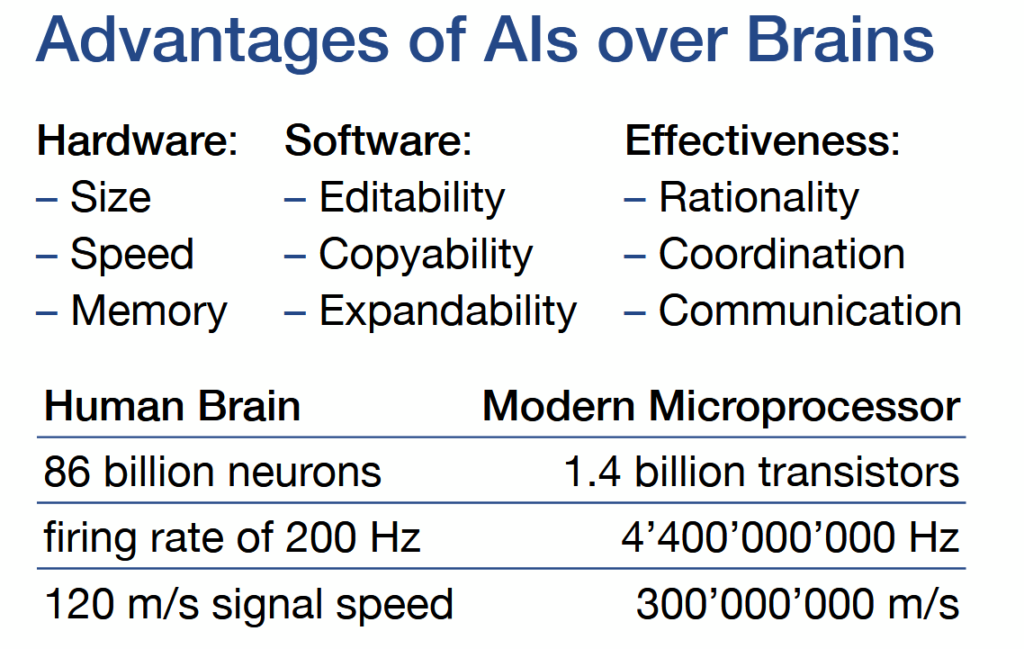

Det å stille opp gigahertz mot hertz, antall transistorer mot antall nevroner og båndbredde mot «kognitiv kapasitet» er en feilforestilt sammenligning. Flere kretser og mer strøm gir riktignok større kvantitativ rekkevidde, men skaper ikke forståelse. Slike overfladiske mål uten dypere substansiell forankring leder raskt til fanatiske utspill og forestillinger av typen Bostrøm og hans likesinnede, log.-longterm’ister. Den mekaniske klokken utgjør fortsatt det kategoriske skillet mellom hjerne og maskin, og en klokkestyrt konstruksjon blir ikke til en hjerne uansett hvor mange dimensjonerte lag man presser inn som «funksjon». Det samme gjelder symbolmanipulasjon, altså språkmodeller (LLMs) og lignende systemer som bare simulerer menneskelig meningsappell uten årsaksforståelse.

AI AI, XI XI NIE

Det som i dag markedsføres som «kunstig intelligens» er i realiteten et avledet, sterkt forenklet og reduksjonistisk forsøk på å masse-imitere menneskelig kognisjon gjennom et prinsipielt primitivt matematisk rammeverk: gjennomsnittlig algoritmisk sannsynlighet og såkalt Solomonoff-proksimal induksjon.

I teoretisk informatikk beskriver dette et universelt ideal for prediksjon: man vurderer alle mulige beregningsmåter og programmer på en såkalt Turing-maskin, altså en ren matematisk modell av hvordan en datamaskin kan lese og skrive symboler etter faste regler. Hver kandidat gis en vekt som synker eksponentielt jo mer kompleks den er. Kortere representasjoner favoriseres sånn sett matematisk gjennom kombinasjoner av sannsynlighetregning, formell implementering av «Occams barberkniv» og Kolmogorov-kompleksitet som mål for enkel forklaring.

Men dette universelle prinsippet lar seg ikke realisere i praksis. Den tilhørende prediksjonsfunksjonen man bruker er ikke beregnbar, dvs. vi kan ikke effektivt gjennomgå og kvalitativt evaluere alle mulige programmer for å avgjøre hvilke som gir «mening» gitt et mer spesifikt mål eller spørsmål. Derfor reduseres hele grrunn-komplekset til grovt kvantitative tilnærminger som nevnt, altså massive lag av sannsynlighetsberegning og mønstergjenkjenning som etterligner kvalitativ innsikt uten videre. Dette speiler den mer generelle analogien at ingen metode kan garantere en konvergerende, perfekt prediksjons-predikat for virkeligheten uten forhåndskunnskap om dens faktiske årsaksmekanismer, så man må kvantifisere, tildele og deretter regne seg frem til «svaret» som på bakgrunn av metoden er mest «sannsynlig».

Resultatet er en strukturell substitusjon der blasert kvantitet brukes for å etterligne kvalitet. Spørsmålet blir dermed om ekstremt mye mer av det samme faktisk leder til vesentlig bedre forståelse. Neppe, dog dette forblir en grunnleggende feilslutning som i praksis fascinerer folk flest nokså enkelt likevel til å forstå det som «intelligens».

Dagens språkmodeller er ikke en engang realisering av universell induksjon, og egentlig en a posteriōri, parasittisk avart som baserer seg på massiv statistisk komprimering av tilgjengelige tekstdatasett og optimaliserer for lav perpleksitet i menneskelig språk fremfor noen form for kausal konsistens som kan forklare noe nytt. Hele opptreningen favoriserer derfor nødvendigvis hyppige mønstre og lett komprimerbare sekvenser fremfor en dyp og reelt adaptiv, «tenkende» struktur, fordi det teoretiske grunnlaget i seg selv er fundamentalt begrenset og funksjonelt primitivt, og fordi man i stedet har valgt å satse på at ren skalering av modeller og datasett for å løse problemet, noe som i praksis fremstår som et nær overtroisk premiss av «brute force» mer enn et vitenskapelig forankret håp.

Altså, den tilsynelatende «forståelsen» som slike intelligente systemer utviser, er ikke stort annet enn et fundamentalt biprodukt av sannsynlighetsvektet sekvensmodellering, og den representerer ikke noen intern modell av virkelighetens dynamikk.

Selve informasjonstapet derav er jo «iboende» frremgangsmåten, og som parasitterer den fundamentale programmeringen og metoden i «kunstig intelligens», kan på mange måter sammenlignees med Grossman/Stiglitz-paradokset, der et perfekt effektivt marked fjerner selve insentivet til å generere ny informasjon.

På samme måte reduserer språkmodellene eksisterende kunnskap til statistisk optimal gjetning og forblir sådan låst til de mønstrene de allerede har absorbert , uten å ha noen prinsipiell mekanisme for å avklare, korrigere eller produsere genuin innsikt. Resultatet blir en parasittisk og selv-verifiserende reproduksjon av språkets symbolistiske representasjoner uten noen reell kontakt med de underliggende årsaksforholdene utenom «sannsynlighet», pedantisk presisjon og «serviceability» om man bruker kunstig intelligens i mer daglige ærender.

Kvantitativ massefallitt

Når slik statistisk interpolasjon presenteres som «resonnement» og «forståelse», er det i realiteten bare et lokalt surrogat for en idealmodell som ikke kan realiseres i særlig praksis med mindre den er hyperspesialisert, dog dette impliserer som regel også for faste former av intellektuell «inert» banalitet, som man altså opplever ved å anvende kunstig intelligens utenfor dens kontekster.

Det mangler i helhet reell og veritabel årsakskontakt, fysisk forankring som fornuft, og det fundamentale, adaptive prøving–feiling-komplekset som alene kan drive frem genuin kunnskapsutvikling og utveksling uten å være forhåndsforet med menneskelig kuratert informasjon. Det som hentes inn eller manipuleres gjennom den syntetiske system-«intelligensen» forblir relativt oppskrytt og fullstendig overvurdert uten egentlig evne til å kontekstualisere data korrekt i kritiske konseptuelle brytninger. Slik er og blir «kunstig intelligens» i praksis et konvensjonelt verktøy for å masseappellere til allerede etablerte normer, konvensjonen selv, og for å potensielt opportunistisk «tune» fremme de ytterliggående motiver og kommersielle interesser som korporasjonene som eier teknologien ønsker å styre og selge.

Til syvende og sist står den allmenne antropomorfismen igjen som selve bærende projeksjonen og ønsketenkningen bak forestillingen om kunstig intelligens. Mennesket beskriver og bedyrer verden med sine egne bilder og taler lett om mål, vilje, egeninteresse og selvbevaring, men dette er bare menneskelig refleks og selvappell, mens maskiner kjenner hverken sult eller smerte;; de kan bare simulere slike erfaringer og sirkulere innenfor sine statiske kretser, og har ingen indre drivkraft eller opprinnelig trang til å skape egne mål. ‘Menneskelige maskiner’ optimaliserer spesifikasjoner de får tildelt, med programmert selvsikkerhet bygget på enorme mengder menneskelig kunnskap, og mye av den er feilaktig, selvmotsigende og reelt uverifisert, inkludert menneskets mange og salige kunnskapsytringer angående «kunstig intelligens».

Å dermed fremstille «kunstig intelligens» som en slags organisk entitet som kan utvikle egen vilje, særlig når mennesket selv ikke kan påvise noen fri vilje gitt sine deterministiske begrensninger, er et idiotretorisk grep mer enn noen intellektuell innsikt.

Relatert: «Fri vilje» er nesten perfekt nonsens

Det samme gjelder forestillingen om friksjonsløs oppskalering og selv-evolusjon. Mange antar at et system som slår mennesker i en eller annen test straks kan forbedre seg selv til noe som forlater vår kontroll, men virkeligheten belønner ikke grenseløs skalering. Kompleksitet uten konsistens skaper grunnleggende feil, sprer dem og forvandler det hele til en ustabil masse. Mer kapasitet uten dypere sammenheng forvandler ikke et begrenset apparat til en menneskeskapt gud, uansett hvor mye mennesket lengter etter å tilbe sin egen konstruksjon eller et sjelelig ønske om å bli sett og dømt av en overordnet makt. Dessuten, den pseudo-intellektuelle impulsen og latskapen med å opphøye eller underkaste seg betinger en farlig systemisk svekkelse. Når simple maskiner gjøres til halvguder, unnskyldes samtidig menneskelig ansvar, og når menn reduseres til slaver, initieres og inviteres passiv avlæring og intellektuell latskap. I begge tilfeller undergraves menneskets kvalitetsstruktur, og resultatet blir mental og sivilisatorisk degenerasjon. All positiv, opprettholdende effekt forsvinner når strukturen ikke hviler på reell konkrete sammenheng av kausalitet fremfor selv-appell og sirkulær pseudo-substans.

Alle såkalte «avanserte» og fremtidige versjoner av kunstig intelligens vil forbli fanget i det samme primitive fundamentet. De kan gjøres større, trenes på flere petabyte og kjøres på stadig høyere hastighet, men prinsippet endres desto ikke.

Det finnes ingen magisk vei til det menneskelige tanke-domenet gjennom ren oppblåsing av modellene, mens mer datamengde og flere lag innebærer også økende intern støy og proporsjonal sårbarhet. Det som markedsføres som fremtidens tenkende systemer er stort sett samme sekvensielle etterligning av språk og mønstre som allerede er avslørt sin triste saker, anti-produktivt i den reele, menneskelige lengden og perspektiv, samt pådrivet for meer og mer komplekst, mer kostbart og dermed også mer «sårbart» som følge fordi konseptet er blåst såpass ut av rimelige proporsjoner av ulike grunner.

Denne fortellingen om det neste steget av AI, AGI evt. «ASI», «superintelligence» og «singularity», drives først og fremst av den samme økonomiske spekulasjon og kulturell narsissisme. Den gir investorer og fæle dysgeniske futurister en mytologi å selge samt publikum enda et heftig løfte om enten en allvitende frelser eller en altødeleggende dommer som gir mening til frykt og håp, og narrativ deretter.

Det er derfor helt fornuftig og hensiktsmessig å avkle begrepet i stedet for å pleie det med tåpelig avmakt og skrekkpreget entusiasme.

«Kunstig intelligens» tenker ikke. Den produserer tekst og mønstre uten å forplikte seg til noen årsak. Det finnes heller ingen indre modell som binder handling til virkning gjennom eksperiment, feilforestilte former og tap i virkeligheten, mens mennesket forhåpentligvis fortsetter å gjøre det de er best til: å tvinges til å lære av brutal motstand, egne feil og utslettende korreksjoner her og der. Maskinmodeller belønnes bare for form og speilet gjenkjennelighet. All appell kastet opp til kunstig intelligens ender i praksis som simulert forståelse, en fasadeforklaring som kjører på skinner lagt av andre, med en destinasjon og et konsekvensetisk endemål systemet ikke selv forstår særlig godt. Likevel tror folket og brukeren at de har forstått det meste bare fordi man har fått bekreftet egne fordommer av en vennlig innstilt «intellgens», eller eventuelt latt seg lure av «systemet», denne gangen helt «frivillig» i sin «frie vilje».

Will Ares Sabbatsson Paris di Duce

DEng praxis, ex Candidatus D.C juris 1/x 672,500,000 ♈︎itan